第一章、flink实时数仓入门

一、依赖

<!--

Licensed to the Apache Software Foundation (ASF) under one

or more contributor license agreements. See the NOTICE file

distributed with this work for additional information

regarding copyright ownership. The ASF licenses this file

to you under the Apache License, Version 2.0 (the

"License"); you may not use this file except in compliance

with the License. You may obtain a copy of the License at

http://www.apache.org/licenses/LICENSE-2.0

Unless required by applicable law or agreed to in writing,

software distributed under the License is distributed on an

"AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

KIND, either express or implied. See the License for the

specific language governing permissions and limitations

under the License.

-->

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.dajiangtai</groupId>

<artifactId>learning-flink</artifactId>

<version>1.0</version>

<packaging>jar</packaging>

<name>Flink Quickstart Job</name>

<url>http://www.myorganization.org</url>

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<flink.version>1.6.2</flink.version>

<java.version>1.8</java.version>

<scala.binary.version>2.11</scala.binary.version>

<maven.compiler.source>${java.version}</maven.compiler.source>

<maven.compiler.target>${java.version}</maven.compiler.target>

</properties>

<repositories>

<repository>

<id>apache.snapshots</id>

<name>Apache Development Snapshot Repository</name>

<url>https://repository.apache.org/content/repositories/snapshots/</url>

<releases>

<enabled>false</enabled>

</releases>

<snapshots>

<enabled>true</enabled>

</snapshots>

</repository>

</repositories>

<dependencies>

<!-- Apache Flink dependencies -->

<!-- These dependencies are provided, because they should not be packaged into the JAR file. -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-scala_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-scala_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-connector-kafka-0.10 -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka-0.10_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.bahir/flink-connector-redis -->

<dependency>

<groupId>org.apache.bahir</groupId>

<artifactId>flink-connector-redis_2.11</artifactId>

<version>1.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-hadoop-compatibility_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-hbase_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

<exclusions>

<exclusion>

<artifactId>protobuf-java</artifactId>

<groupId>com.google.protobuf</groupId>

</exclusion>

</exclusions>

</dependency>

<!--************************sql***************************-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-json -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-json</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-jdbc -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-jdbc</artifactId>

<version>${flink.version}</version>

</dependency>

<!--************************sql***************************-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-table_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.35</version>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>fastjson</artifactId>

<version>1.2.54</version>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<version>1.18.0</version>

<!--<scope>provided</scope>-->

</dependency>

<dependency>

<groupId>com.google.protobuf</groupId>

<artifactId>protobuf-java</artifactId>

<version>2.5.0</version>

</dependency>

<dependency>

<groupId>com.alibaba.otter</groupId>

<artifactId>canal.client</artifactId>

<version>1.1.2</version>

</dependency>

<dependency>

<groupId>com.cloudwise.toushibao</groupId>

<artifactId>simulatedata-generator</artifactId>

<version>0.0.1</version>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>1.7.7</version>

<scope>runtime</scope>

</dependency>

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.17</version>

<scope>runtime</scope>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-shaded-hadoop2</artifactId>

<version>${flink.version}</version>

<!--<scope>provided</scope>-->

</dependency>

</dependencies>

<build>

<plugins>

<!-- Java Compiler -->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.1</version>

<configuration>

<source>${java.version}</source>

<target>${java.version}</target>

</configuration>

</plugin>

<!-- scala编译插件 -->

<plugin>

<groupId>net.alchim31.maven</groupId>

<artifactId>scala-maven-plugin</artifactId>

<version>3.1.6</version>

<configuration>

<scalaCompatVersion>2.11</scalaCompatVersion>

<scalaVersion>2.11.12</scalaVersion>

<encoding>UTF-8</encoding>

</configuration>

<executions>

<execution>

<id>compile-scala</id>

<phase>compile</phase>

<goals>

<goal>add-source</goal>

<goal>compile</goal>

</goals>

</execution>

<execution>

<id>test-compile-scala</id>

<phase>test-compile</phase>

<goals>

<goal>add-source</goal>

<goal>testCompile</goal>

</goals>

</execution>

</executions>

</plugin>

<!-- We use the maven-shade plugin to create a fat jar that contains all necessary dependencies. -->

<!-- Change the value of <mainClass>...</mainClass> if your program entry point changes. -->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>3.0.0</version>

<executions>

<!-- Run shade goal on package phase -->

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<artifactSet>

<excludes>

<exclude>org.apache.flink:force-shading</exclude>

<exclude>com.google.code.findbugs:jsr305</exclude>

<exclude>org.slf4j:*</exclude>

<exclude>log4j:*</exclude>

</excludes>

</artifactSet>

<filters>

<filter>

<!-- Do not copy the signatures in the META-INF folder.

Otherwise, this might cause SecurityExceptions when using the JAR. -->

<artifact>*:*</artifact>

<excludes>

<exclude>META-INF/*.SF</exclude>

<exclude>META-INF/*.DSA</exclude>

<exclude>META-INF/*.RSA</exclude>

</excludes>

</filter>

</filters>

<transformers>

<transformer implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer">

<mainClass>com.dajiangtai.StreamingJob</mainClass>

</transformer>

</transformers>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

<pluginManagement>

<plugins>

<!-- This improves the out-of-the-box experience in Eclipse by resolving some warnings. -->

<plugin>

<groupId>org.eclipse.m2e</groupId>

<artifactId>lifecycle-mapping</artifactId>

<version>1.0.0</version>

<configuration>

<lifecycleMappingMetadata>

<pluginExecutions>

<pluginExecution>

<pluginExecutionFilter>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<versionRange>[3.0.0,)</versionRange>

<goals>

<goal>shade</goal>

</goals>

</pluginExecutionFilter>

<action>

<ignore/>

</action>

</pluginExecution>

<pluginExecution>

<pluginExecutionFilter>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<versionRange>[3.1,)</versionRange>

<goals>

<goal>testCompile</goal>

<goal>compile</goal>

</goals>

</pluginExecutionFilter>

<action>

<ignore/>

</action>

</pluginExecution>

</pluginExecutions>

</lifecycleMappingMetadata>

</configuration>

</plugin>

</plugins>

</pluginManagement>

</build>

<!-- This profile helps to make things run out of the box in IntelliJ -->

<!-- Its adds Flink's core classes to the runtime class path. -->

<!-- Otherwise they are missing in IntelliJ, because the dependency is 'provided' -->

<profiles>

<profile>

<id>add-dependencies-for-IDEA</id>

<activation>

<property>

<name>idea.version</name>

</property>

</activation>

<dependencies>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

<scope>compile</scope>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

<scope>compile</scope>

</dependency>

</dependencies>

</profile>

</profiles>

</project>

二、Flink DataSet API编程指南

Flink最大的亮点是实时处理部分,Flink认为批处理是流处理的特殊情况,可以通过一套引擎处理批量和流式数据,而Flink在未来也会重点投入更多的资源到批流融合中。我在Flink DataStream API编程指南中介绍了DataStream API的使用,在本文中将介绍Flink批处理计算的DataSet API的使用。通过本文你可以了解:

DataSet转换操作(Transformation)

Source与Sink的使用

广播变量的基本概念与使用Demo

分布式缓存的概念及使用Demo

DataSet API的Transformation使用Demo案例

正文开始hē hē hē hē

1、WordCount示例

在开始讲解DataSet API之前,先看一个Word Count的简单示例,来直观感受一下DataSet API的编程模型,具体代码如下:

public class WordCount {

public static void main(String[] args) throws Exception {

// 用于批处理的执行环境

ExecutionEnvironment env = ExecutionEnvironment.getExecutionEnvironment();

// 数据源

DataSource<String> stringDataSource = env.fromElements("hello Flink What is Apache Flink");

// 转换

AggregateOperator<Tuple2<String, Integer>> wordCnt = stringDataSource

.flatMap(new FlatMapFunction<String, Tuple2<String, Integer>>() {

@Override

public void flatMap(String value, Collector<Tuple2<String, Integer>> out) throws Exception {

String[] split = value.split(" ");

for (String word : split) {

out.collect(Tuple2.of(word, 1));

}

}

})

.groupBy(0)

.sum(1);

// 输出

wordCnt.print();

}

}

从上面的示例中可以看出,基本的编程模型是:

获取批处理的执行环境ExecutionEnvironment

加载数据源

转换操作

数据输出

下面会对数据源、转换操作、数据输出进行一一解读。

2、Data Source

DataSet API支持从多种数据源中将批量数据集读到Flink系统中,并转换成DataSet数据集。主要包括三种类型:分别是基于文件的、基于集合的及通用类数据源。同时在DataSet API中可以自定义实现InputFormat/RichInputFormat接口,以接入不同数据格式类型的数据源,比如CsvInputFormat、TextInputFormat等。从ExecutionEnvironment类提供的方法中可以看出支持的数据源方法,如下图所示:

1、基于文件的数据源

readTextFile(path) / TextInputFormat

解释

读取文本文件,传递文件路径参数,并将文件内容转换成DataSet类型数据集。

使用

// 读取本地文件

DataSet<String> localLines = env.readTextFile("file:///path/to/my/textfile");

// 读取HDSF文件

DataSet<String> hdfsLines = env.readTextFile("hdfs://nnHost:nnPort/path/to/my/textfile");

readTextFileWithValue(path)/ TextValueInputFormat

解释

读取文本文件内容,将文件内容转换成DataSet[StringValue]类型数据集。该方法与readTextFile(String)不同的是,其泛型是StringValue,是一种可变的String类型,通过StringValue存储文本数据可以有效降低String对象创建数量,减小垃圾回收的压力。

使用

// 读取本地文件

DataSet<StringValue> localLines = env.readTextFileWithValue("file:///some/local/file");

// 读取HDSF文件

DataSet<StringValue> hdfsLines = env.readTextFileWithValue("hdfs://host:port/file/path");

readCsvFile(path)/ CsvInputFormat

解释

创建一个CSV的reader,读取逗号分隔(或其他分隔符)的文件。可以直接转换成Tuple类型、POJOs类的DataSet。在方法中可以指定行切割符、列切割符、字段等信息。

使用

// read a CSV file with five fields, taking only two of them

// 读取一个具有5个字段的CSV文件,只取第一个和第四个字段

DataSet<Tuple2<String, Double>> csvInput = env.readCsvFile("hdfs:///the/CSV/file")

.includeFields("10010")

.types(String.class, Double.class);

// 读取一个有三个字段的CSV文件,将其转为POJO类型

DataSet<Person>> csvInput = env.readCsvFile("hdfs:///the/CSV/file")

.pojoType(Person.class, "name", "age", "zipcode");

readFileOfPrimitives(path, Class) / PrimitiveInputFormat

解释

读取一个原始数据类型(如String,Integer)的文件,返回一个对应的原始类型的DataSet集合

使用

DataSet<String> Data = env.readFileOfPrimitives("file:///some/local/file", String.class);

2、基于集合的数据源

fromCollection(Collection)

解释

从java的集合中创建DataSet数据集,集合中的元素数据类型相同

使用

DataSet<String> data= env.fromCollection(arrayList);

fromElements(T ...)

解释

从给定数据元素序列中创建DataSet数据集,且所有的数据对象类型必须一致

使用

DataSet<String> stringDataSource = env.fromElements("hello Flink What is Apache Flink");

generateSequence(from, to)

解释

指定from到to范围区间,然后在区间内部生成数字序列数据集,由于是并行处理的,所以最终的顺序不能保证一致。

使用

DataSet<Long> longDataSource = env.generateSequence(1, 20);

3、通用类型数据源

DataSet API中提供了Inputformat通用的数据接口,以接入不同数据源和格式类型的数据。InputFormat接口主要分为两种类型:一种是基于文件类型,在DataSet API对应readFile()方法;另外一种是基于通用数据类型的接口,例如读取RDBMS或NoSQL数据库中等,在DataSet API中对应createInput()方法。

readFile(inputFormat, path) / FileInputFormat

解释

自定义文件类型输入源,将指定格式文件读取并转成DataSet数据集

使用

env.readFile(new MyInputFormat(), "file:///some/local/file");

createInput(inputFormat) / InputFormat

解释

自定义通用型数据源,将读取的数据转换为DataSet数据集。如以下实例使用Flink内置的JDBCInputFormat,创建读取mysql数据源的JDBCInput Format,完成从mysql中读取Person表,并转换成DataSet [Row]数据集

使用

DataSet<Tuple2<String, Integer> dbData =

env.createInput(

JDBCInputFormat.buildJDBCInputFormat()

.setDrivername("com.mysql.jdbc.Driver")

.setDBUrl("jdbc:mysql://localhost/mydb")

.setQuery("select name, age from stu")

.setRowTypeInfo(new RowTypeInfo(BasicTypeInfo.STRING_TYPE_INFO, BasicTypeInfo.INT_TYPE_INFO))

.finish()

);

3、Data Sink

Flink在DataSet API中的数据输出共分为三种类型。第一种是基于文件实现,对应DataSet的write()方法,实现将DataSet数据输出到文件系统中。第二种是基于通用存储介质实现,对应DataSet的output()方法,例如使用JDBCOutputFormat将数据输出到关系型数据库中。最后一种是客户端输出,直接将DataSet数据从不同的节点收集到Client,并在客户端中输出,例如DataSet的print()方法。

• writeAsText() / TextOutputFormat:以字符串的形式逐行写入元素。字符串是通过调用每个

元素的toString()方法获得的

• writeAsFormattedText() / TextOutputFormat:以字符串的形式逐行写入元素。字符串是通

过为每个元素调用用户定义的format()方法获得的。

• writeAsCsv(...) / CsvOutputFormat:将元组写入以逗号分隔的文件。行和字段分隔符是可

配置的。每个字段的值来自对象的toString()方法。

• print() / printToErr() / print(String msg) / printToErr(String msg) ()(注: 线上应用杜绝使用,

采用抽样打印或者日志的方式)

• write() / FileOutputFormat

• output()/ OutputFormat:通用的输出方法,用于不基于文件的数据接收器(如将结果存储在

数据库中)。

1、标准的数据输出方法

// 文本数据

DataSet<String> textData = // [...]

// 将数据写入本地文件

textData.writeAsText("file:///my/result/on/localFS");

// 将数据写入HDFS文件

textData.writeAsText("hdfs://nnHost:nnPort/my/result/on/localFS");

// 写数据到本地文件,如果文件存在则覆盖

textData.writeAsText("file:///my/result/on/localFS", WriteMode.OVERWRITE);

// 将数据输出到本地的CSV文件,指定分隔符为"|"

DataSet<Tuple3<String, Integer, Double>> values = // [...]

values.writeAsCsv("file:///path/to/the/result/file", "\n", "|");

// 使用自定义的TextFormatter对象

values.writeAsFormattedText("file:///path/to/the/result/file",

new TextFormatter<Tuple2<Integer, Integer>>() {

public String format (Tuple2<Integer, Integer> value) {

return value.f1 + " - " + value.f0;

}

});

2、使用自定义的输出类型

DataSet<Tuple3<String, Integer, Double>> myResult = [...]

// 将tuple类型的数据写入关系型数据库

myResult.output(

// 创建并配置OutputFormat

JDBCOutputFormat.buildJDBCOutputFormat()

.setDrivername("com.mysql.jdbc.Driver")

.setDBUrl("jdbc:mysql://localhost/mydb")

.setQuery("insert into persons (name, age, height) values (?,?,?)")

.finish()

);

3、 Flink 写入数据到 ElasticSearch

依赖:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-elasticsearch6_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

</dependency>

ElasticSearchSinkUtil 工具类

public class ElasticSearchSinkUtil {

/**

* es sink

*

* @param hosts es hosts

* @param bulkFlushMaxActions bulk flush size

* @param parallelism 并行数

* @param data 数据

* @param func

* @param <T>

*/

public static <T> void addSink(List<HttpHost> hosts, int bulkFlushMaxActions, int parallelism,

SingleOutputStreamOperator<T> data, ElasticsearchSinkFunction<T> func) {

ElasticsearchSink.Builder<T> esSinkBuilder = new ElasticsearchSink.Builder<>(hosts, func);

esSinkBuilder.setBulkFlushMaxActions(bulkFlushMaxActions);

data.addSink(esSinkBuilder.build()).setParallelism(parallelism);

}

/**

* 解析配置文件的 es hosts

*

* @param hosts

* @return

* @throws MalformedURLException

*/

public static List<HttpHost> getEsAddresses(String hosts) throws MalformedURLException {

String[] hostList = hosts.split(",");

List<HttpHost> addresses = new ArrayList<>();

for (String host : hostList) {

if (host.startsWith("http")) {

URL url = new URL(host);

addresses.add(new HttpHost(url.getHost(), url.getPort()));

} else {

String[] parts = host.split(":", 2);

if (parts.length > 1) {

addresses.add(new HttpHost(parts[0], Integer.parseInt(parts[1])));

} else {

throw new MalformedURLException("invalid elasticsearch hosts format");

}

}

}

return addresses;

}

}

Main 启动类

public class Main {

public static void main(String[] args) throws Exception {

//获取所有参数

final ParameterTool parameterTool = ExecutionEnvUtil.createParameterTool(args);

//准备好环境

StreamExecutionEnvironment env = ExecutionEnvUtil.prepare(parameterTool);

//从kafka读取数据

DataStreamSource<Metrics> data = KafkaConfigUtil.buildSource(env);

//从配置文件中读取 es 的地址

List<HttpHost> esAddresses = ElasticSearchSinkUtil.getEsAddresses(parameterTool.get(ELASTICSEARCH_HOSTS));

//从配置文件中读取 bulk flush size,代表一次批处理的数量,这个可是性能调优参数,特别提醒

int bulkSize = parameterTool.getInt(ELASTICSEARCH_BULK_FLUSH_MAX_ACTIONS, 40);

//从配置文件中读取并行 sink 数,这个也是性能调优参数,特别提醒,这样才能够更快的消费,防止 kafka 数据堆积

int sinkParallelism = parameterTool.getInt(STREAM_SINK_PARALLELISM, 5);

//自己再自带的 es sink 上一层封装了下

ElasticSearchSinkUtil.addSink(esAddresses, bulkSize, sinkParallelism, data,

(Metrics metric, RuntimeContext runtimeContext, RequestIndexer requestIndexer) -> {

requestIndexer.add(Requests.indexRequest()

.index(ZHISHENG + "_" + metric.getName()) //es 索引名

.type(ZHISHENG) //es type

.source(GsonUtil.toJSONBytes(metric), XContentType.JSON));

});

env.execute("flink learning connectors es6");

/**

DataStream<String> input = ...;

input.addSink(new ElasticsearchSink<>(

config, transportAddresses,

new ElasticsearchSinkFunction<String>() {...},

new ActionRequestFailureHandler() {

@Override

void onFailure(ActionRequest action,

Throwable failure,

int restStatusCode,

RequestIndexer indexer) throw Throwable {

if (ExceptionUtils.containsThrowable(failure, EsRejectedExecutionException.class)) {

// full queue; re-add document for indexing

indexer.add(action);

} else if (ExceptionUtils.containsThrowable(failure, ElasticsearchParseException.class)) {

// malformed document; simply drop request without failing sink

} else {

// for all other failures, fail the sink

// here the failure is simply rethrown, but users can also choose to throw custom exceptions

throw failure;

}

}

}));

**/

}

}

配置文件

kafka.brokers=localhost:9092

kafka.group.id=zhisheng-metrics-group-test

kafka.zookeeper.connect=localhost:2181

metrics.topic=zhisheng-metrics

stream.parallelism=5

stream.checkpoint.interval=1000

stream.checkpoint.enable=false

elasticsearch.hosts=localhost:9200

elasticsearch.bulk.flush.max.actions=40

stream.sink.parallelism=5

配置优化

1、bulk.flush.backoff.enable 用来表示是否开启重试机制

2、bulk.flush.backoff.type 重试策略,有两种:EXPONENTIAL 指数型(表示多次重试之间的时间间隔按照指数方式进行增长)、CONSTANT 常数型(表示多次重试之间的时间间隔为固定常数)

3、bulk.flush.backoff.delay 进行重试的时间间隔

4、bulk.flush.backoff.retries 失败重试的次数

5、bulk.flush.max.actions: 批量写入时的最大写入条数

6、bulk.flush.max.size.mb: 批量写入时的最大数据量

7、bulk.flush.interval.ms: 批量写入的时间间隔,配置后则会按照该时间间隔严格执行,无视上面的两个批量写入配置

3、Flink 写入数据到 Kafka

依赖:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka-0.11_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

配置文件

kafka.brokers=xxx:9092,xxx:9092,xxx:9092

kafka.group.id=metrics-group-test

kafka.zookeeper.connect=xxx:2181

metrics.topic=xxx

stream.parallelism=5

kafka.sink.brokers=localhost:9092

kafka.sink.topic=metric-test

stream.checkpoint.interval=1000

stream.checkpoint.enable=false

stream.sink.parallelism=5

代码:

public class Main {

public static void main(String[] args) throws Exception{

final ParameterTool parameterTool = ExecutionEnvUtil.createParameterTool(args);

StreamExecutionEnvironment env = ExecutionEnvUtil.prepare(parameterTool);

DataStreamSource<Metrics> data = KafkaConfigUtil.buildSource(env);

data.addSink(new FlinkKafkaProducer011<Metrics>(

parameterTool.get("kafka.sink.brokers"),

parameterTool.get("kafka.sink.topic"),

new MetricSchema()

)).name("flink-connectors-kafka")

.setParallelism(parameterTool.getInt("stream.sink.parallelism"));

env.execute("flink learning connectors kafka");

}

}

执行命令可以查看该 topic 的信息:

bin/kafka-topics.sh --describe --zookeeper localhost:2181 --topic metric-test

4、Flink 读取 Kafka 数据批量写入到 MySQL

依赖

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.34</version>

</dependency>

读取 kafka 数据

package com.zhisheng.connectors.mysql.utils;

import com.zhisheng.common.utils.GsonUtil;

import com.zhisheng.connectors.mysql.model.Student;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Properties;

/**

* Desc: 往kafka中写数据,可以使用这个main函数进行测试

* Created by zhisheng on 2019-02-17

* Blog: http://www.54tianzhisheng.cn/tags/Flink/

*/

public class KafkaUtil {

public static final String broker_list = "localhost:9092";

public static final String topic = "student"; //kafka topic 需要和 flink 程序用同一个 topic

public static void writeToKafka() throws InterruptedException {

Properties props = new Properties();

props.put("bootstrap.servers", broker_list);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

KafkaProducer producer = new KafkaProducer<String, String>(props);

for (int i = 1; i <= 100; i++) {

Student student = new Student(i, "zhisheng" + i, "password" + i, 18 + i);

ProducerRecord record = new ProducerRecord<String, String>(topic, null, null, GsonUtil.toJson(student));

producer.send(record);

System.out.println("发送数据: " + GsonUtil.toJson(student));

Thread.sleep(10 * 1000); //发送一条数据 sleep 10s,相当于 1 分钟 6 条

}

producer.flush();

}

public static void main(String[] args) throws InterruptedException {

writeToKafka();

}

}

写入数据库

依赖:

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-dbcp2</artifactId>

<version>2.1.1</version>

</dependency>

MySQL工具类

package com.zhisheng.connectors.mysql.sinks;

import com.zhisheng.connectors.mysql.model.Student;

import org.apache.commons.dbcp2.BasicDataSource;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.functions.sink.RichSinkFunction;

import javax.sql.DataSource;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.util.List;

/**

* Desc: 数据批量 sink 数据到 mysql

* Created by zhisheng_tian on 2019-02-17

* Blog: http://www.54tianzhisheng.cn/tags/Flink/

*/

public class SinkToMySQL extends RichSinkFunction<List<Student>> {

PreparedStatement ps;

BasicDataSource dataSource;

private Connection connection;

/**

* open() 方法中建立连接,这样不用每次 invoke 的时候都要建立连接和释放连接

*

* @param parameters

* @throws Exception

*/

@Override

public void open(Configuration parameters) throws Exception {

super.open(parameters);

dataSource = new BasicDataSource();

connection = getConnection(dataSource);

String sql = "insert into Student(id, name, password, age) values(?, ?, ?, ?);";

ps = this.connection.prepareStatement(sql);

}

@Override

public void close() throws Exception {

super.close();

//关闭连接和释放资源

if (connection != null) {

connection.close();

}

if (ps != null) {

ps.close();

}

}

/**

* 每条数据的插入都要调用一次 invoke() 方法

*

* @param value

* @param context

* @throws Exception

*/

@Override

public void invoke(List<Student> value, Context context) throws Exception {

//遍历数据集合

for (Student student : value) {

ps.setInt(1, student.getId());

ps.setString(2, student.getName());

ps.setString(3, student.getPassword());

ps.setInt(4, student.getAge());

ps.addBatch();

}

int[] count = ps.executeBatch();//批量后执行

System.out.println("成功了插入了" + count.length + "行数据");

}

private static Connection getConnection(BasicDataSource dataSource) {

dataSource.setDriverClassName("com.mysql.jdbc.Driver");

//注意,替换成自己本地的 mysql 数据库地址和用户名、密码

dataSource.setUrl("jdbc:mysql://localhost:3306/test");

dataSource.setUsername("root");

dataSource.setPassword("root123456");

//设置连接池的一些参数

dataSource.setInitialSize(10);

dataSource.setMaxTotal(50);

dataSource.setMinIdle(2);

Connection con = null;

try {

con = dataSource.getConnection();

System.out.println("创建连接池:" + con);

} catch (Exception e) {

System.out.println("-----------mysql get connection has exception , msg = " + e.getMessage());

}

return con;

}

}

核心类 Main

public class Main {

public static void main(String[] args) throws Exception{

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("zookeeper.connect", "localhost:2181");

props.put("group.id", "metric-group");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("auto.offset.reset", "latest");

SingleOutputStreamOperator<Student> student = env.addSource(new FlinkKafkaConsumer011<>(

"student", //这个 kafka topic 需要和上面的工具类的 topic 一致

new SimpleStringSchema(),

props)).setParallelism(1)

.map(string -> GsonUtil.fromJson(string, Student.class)); //

student.timeWindowAll(Time.minutes(1)).apply(new AllWindowFunction<Student, List<Student>, TimeWindow>() {

@Override

public void apply(TimeWindow window, Iterable<Student> values, Collector<List<Student>> out) throws Exception {

ArrayList<Student> students = Lists.newArrayList(values);

if (students.size() > 0) {

System.out.println("1 分钟内收集到 student 的数据条数是:" + students.size());

out.collect(students);

}

}

}).addSink(new SinkToMySQL());

env.execute("flink learning connectors kafka");

}

}

5、Flink读取Kafka 数据写到 RabbitMQ

依赖:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-rabbitmq_${scala.binary.version}</artifactId>

<version>${flink.version}</version>

</dependency>

生产者

import com.rabbitmq.client.Channel;

import com.rabbitmq.client.Connection;

import com.rabbitmq.client.ConnectionFactory;

public class RabbitMQProducerUtil {

public final static String QUEUE_NAME = "zhisheng";

public static void main(String[] args) throws Exception {

//创建连接工厂

ConnectionFactory factory = new ConnectionFactory();

//设置RabbitMQ相关信息

factory.setHost("localhost");

factory.setUsername("admin");

factory.setPassword("admin");

factory.setPort(5672);

//创建一个新的连接

Connection connection = factory.newConnection();

//创建一个通道

Channel channel = connection.createChannel();

// 声明一个队列

// channel.queueDeclare(QUEUE_NAME, false, false, false, null);

//发送消息到队列中

String message = "Hello zhisheng";

//我们这里演示发送一千条数据

for (int i = 0; i < 1000; i++) {

channel.basicPublish("", QUEUE_NAME, null, (message + i).getBytes("UTF-8"));

System.out.println("Producer Send +'" + message + i);

}

//关闭通道和连接

channel.close();

connection.close();

}

}

Flink 主程序

import com.zhisheng.common.utils.ExecutionEnvUtil;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.api.java.utils.ParameterTool;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.rabbitmq.RMQSource;

import org.apache.flink.streaming.connectors.rabbitmq.common.RMQConnectionConfig;

/**

* 从 rabbitmq 读取数据

*/

public class Main {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

ParameterTool parameterTool = ExecutionEnvUtil.PARAMETER_TOOL;

//这些配置建议可以放在配置文件中,然后通过 parameterTool 来获取对应的参数值

final RMQConnectionConfig connectionConfig = new RMQConnectionConfig

.Builder().setHost("localhost").setVirtualHost("/")

.setPort(5672).setUserName("admin").setPassword("admin")

.build();

DataStreamSource<String> zhisheng = env.addSource(new RMQSource<>(connectionConfig,

"zhisheng",

true,

new SimpleStringSchema()))

.setParallelism(1);

zhisheng.print();

//如果想保证 exactly-once 或 at-least-once 需要把 checkpoint 开启

// env.enableCheckpointing(10000);

env.execute("flink learning connectors rabbitmq");

}

}

Sink 数据到 RabbitMQ

public class Main1 {

public static void main(String[] args) throws Exception {

final ParameterTool parameterTool = ExecutionEnvUtil.createParameterTool(args);

StreamExecutionEnvironment env = ExecutionEnvUtil.prepare(parameterTool);

DataStreamSource<Metrics> data = KafkaConfigUtil.buildSource(env);

final RMQConnectionConfig connectionConfig = new RMQConnectionConfig

.Builder().setHost("localhost").setVirtualHost("/")

.setPort(5672).setUserName("admin").setPassword("admin")

.build();

//注意,换一个新的 queue,否则也会报错

data.addSink(new RMQSink<>(connectionConfig, "zhisheng001", new MetricSchema()));

env.execute("flink learning connectors rabbitmq");

}

}

6、Flink 读取 Kafka 数据写入到 HBase

依赖

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-client</artifactId>

<version>2.1.5</version>

</dependency>

<dependency>

<groupId>org.apache.phoenix</groupId>

<artifactId>phoenix-core</artifactId>

<version>5.0.0-HBase-2.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>1.8.1</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId>

<version>1.8.1</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients_2.11</artifactId>

<version>1.8.1</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka_2.11</artifactId>

<version>1.8.1</version>

</dependency>

使用flink读取kafka的数据消息

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.enableCheckpointing(1000);

Properties properties = new Properties();

properties.setProperty("bootstrap.servers", "node1:9092");

FlinkKafkaConsumer<String> consumer = new FlinkKafkaConsumer<>("my-test-topic", new SimpleStringSchema(), properties);

//从最早开始消费

consumer.setStartFromEarliest();

DataStream<String> stream = env.addSource(consumer);

stream.print();

//stream.map();

env.execute();

}

写入hbase

import lombok.extern.slf4j.Slf4j;

import org.apache.flink.streaming.api.functions.ProcessFunction;

import org.apache.flink.util.Collector;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.TableName;

import org.apache.hadoop.hbase.client.Connection;

import org.apache.hadoop.hbase.client.ConnectionFactory;

import org.apache.hadoop.hbase.client.Put;

import org.apache.hadoop.hbase.client.Table;

import org.apache.hadoop.hbase.util.Bytes;

@Slf4j

public class HbaseProcess extends ProcessFunction<String, String> {

private static final long serialVersionUID = 1L;

private Connection connection = null;

private Table table = null;

@Override

public void open(org.apache.flink.configuration.Configuration parameters) throws Exception {

try {

// 加载HBase的配置

Configuration configuration = HBaseConfiguration.create();

// 读取配置文件

configuration.addResource(new Path(ClassLoader.getSystemResource("hbase-site.xml").toURI()));

configuration.addResource(new Path(ClassLoader.getSystemResource("core-site.xml").toURI()));

connection = ConnectionFactory.createConnection(configuration);

TableName tableName = TableName.valueOf("test");

// 获取表对象

table = connection.getTable(tableName);

log.info("[HbaseSink] : open HbaseSink finished");

} catch (Exception e) {

log.error("[HbaseSink] : open HbaseSink faild {}", e);

}

}

@Override

public void close() throws Exception {

log.info("close...");

if (null != table) table.close();

if (null != connection) connection.close();

}

@Override

public void processElement(String value, Context ctx, Collector<String> out) throws Exception {

try {

log.info("[HbaseSink] value={}", value);

//row1:cf:a:aaa

String[] split = value.split(":");

// 创建一个put请求,用于添加数据或者更新数据

Put put = new Put(Bytes.toBytes(split[0]));

put.addColumn(Bytes.toBytes(split[1]), Bytes.toBytes(split[2]), Bytes.toBytes(split[3]));

table.put(put);

log.error("[HbaseSink] : put value:{} to hbase", value);

} catch (Exception e) {

log.error("", e);

}

}

}

HbaseSink类

import lombok.extern.slf4j.Slf4j;

import org.apache.flink.streaming.api.functions.sink.SinkFunction;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.TableName;

import org.apache.hadoop.hbase.client.Connection;

import org.apache.hadoop.hbase.client.ConnectionFactory;

import org.apache.hadoop.hbase.client.Put;

import org.apache.hadoop.hbase.client.Table;

import org.apache.hadoop.hbase.util.Bytes;

@Slf4j

public class HbaseSink implements SinkFunction<String> {

@Override

public void invoke(String value, Context context) throws Exception {

Connection connection = null;

Table table = null;

try {

// 加载HBase的配置

Configuration configuration = HBaseConfiguration.create();

// 读取配置文件

configuration.addResource(new Path(ClassLoader.getSystemResource("hbase-site.xml").toURI()));

configuration.addResource(new Path(ClassLoader.getSystemResource("core-site.xml").toURI()));

connection = ConnectionFactory.createConnection(configuration);

TableName tableName = TableName.valueOf("test");

// 获取表对象

table = connection.getTable(tableName);

//row1:cf:a:aaa

String[] split = value.split(":");

// 创建一个put请求,用于添加数据或者更新数据

Put put = new Put(Bytes.toBytes(split[0]));

put.addColumn(Bytes.toBytes(split[1]), Bytes.toBytes(split[2]), Bytes.toBytes(split[3]));

table.put(put);

log.error("[HbaseSink] : put value:{} to hbase", value);

} catch (Exception e) {

log.error("", e);

} finally {

if (null != table) table.close();

if (null != connection) connection.close();

}

}

}

然后修改main方法代码,运行效果一样的。具体区别后续再分析。

// stream.print();

// stream.process(new HbaseProcess());

stream.addSink(new HbaseSink());

7、Flink 读取 Kafka 数据写入到 HDFS

依赖

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-filesystem_2.12</artifactId> <version>$</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka-0.11_2.12</artifactId> <version>$</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.12</artifactId> <version>$</version>

</dependency>

消费直接存到hdfs

/*

* * Flink consumer topic data and store into hdfs.

* * @author smartloli.

* * Created by Mar 15, 2020

*/

publicclass Kafka2Hdfs { privatestatic Logger LOG = LoggerFactory.getLogger(Kafka2Hdfs.class); publicstaticvoid main(String[] args) {

if (args.length != 3) {

LOG.error("kafka(server01:9092), hdfs(hdfs://cluster01/data/),

flink(parallelism=2) must be exist."); return;

}

String bootStrapServer = args[0]; String hdfsPath = args[1]; int parallelism=Integer.parseInt(args[2]); StreamExecutionEnvironment env= StreamExecutionEnvironment.getExecutionEnvironment(); env.enableCheckpointing(5000); env.setParallelism(parallelism); env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime); DataStream<String> transction = env.addSource(new FlinkKafkaConsumer010<>("test_bll_data",new SimpleStringSchema(),configByKafkaServer(bootStrapServer)));

// Storage into hdfs BucketingSink<String> sink = new BucketingSink<>(hdfsPath);

sink.setBucketer(new DateTimeBucketer<String>("yyyy-MM-dd"));

sink.setBatchSize(1024 * 1024 * 1024);

// this is 1GB sink.setBatchRolloverInterval(1000 * 60 * 60); // one hour producer a file into hdfs transction.addSink(sink);

env.execute("Kafka2Hdfs"); }

privatestatic Object configByKafkaServer(String bootStrapServer) { Properties props = new Properties(); props.setProperty("bootstrap.servers", bootStrapServer); props.setProperty("group.id", "test_bll_group"); props.put("enable.auto.commit", "true"); props.put("auto.commit.interval.ms", "1000"); props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer"); props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer"); return props; } }

8、Flink 读取 Kafka 数据写入到 Redis

依赖

dependencies>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients_2.11</artifactId> <version>1.4.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId> <version>1.4.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId> <version>1.4.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka-0.9_2.11</artifactId> <version>1.4.0</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-redis_2.10</artifactId> <version>1.1.5</version>

</dependency>

</dependencies>

Redis工具类

packagecom.scn;

import org.apache.flink.api.common.functions.FlatMapFunction;

import

org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer09;

import org.apache.flink.streaming.connectors.redis.RedisSink;

import org.apache.flink.streaming.connectors.redis.common.config.FlinkJedisPoolConfig;

import org.apache.flink.streaming.connectors.redis.common.mapper.RedisCommand;

import org.apache.flink.streaming.connectors.redis.common.mapper.RedisCommandDescription;

import org.apache.flink.streaming.connectors.redis.common.mapper.RedisMapper;

import org.apache.flink.streaming.util.serialization.SimpleStringSchema;

import org.apache.flink.util.Collector;

import java.util.Properties;

public class FilnkCostKafka{

public static void main(String[] args)throws Exception {

final StreamExecutionEnvironment env= StreamExecutionEnvironment.getExecutionEnvironment(); env.enableCheckpointing(1000);

Properties properties= new Properties();

properties.setProperty("bootstrap.servers", "192.168.1.20:9092");

properties.setProperty("zookeeper.connect", "192.168.1.20:2181");

properties.setProperty("group.id","test");

FlinkKafkaConsumer09<String> myConsumer=new FlinkKafkaConsumer09<String>("test",new SimpleStringSchema(),properties);

DataStream<String> stream= env.addSource(myConsumer);

DataStream<Tuple2<String,Integer>> counts= stream.flatMap(new LineSplitter()).keyBy(0).sum(1);

//实例化Flink和Redis关联类FlinkJedisPoolConfig,设置Redis端口

FlinkJedisPoolConfig conf=new FlinkJedisPoolConfig.Builder().setHost("127.0.0.1").build();

//实例化RedisSink,并通过flink的addSink的方式将flink计算的结果插入到redis

counts.addSink(new RedisSink<Tuple2<String, Integer>>(conf,new RedisExampleMapper()));

env.execute("WordCount from Kafka data");

}

public static final class LineSplitter implements FlatMapFunction<String, Tuple2<String, Integer>>

{

privatestaticfinallong serialVersionUID = 1L;

public void flatMap(String value,Collector<Tuple2<String, Integer>>out){String[] tokens= value.toLowerCase().split("\\W+");

for (String token : tokens)

{

if (token.length() > 0)

{

out.collect(new Tuple2<String, Integer>(token, 1));

}

}

}

}

//指定Redis key并将flink数据类型映射到Redis数据类型

public static final class RedisExampleMapper implements RedisMapper<Tuple2<String,Integer>>

{

public RedisCommandDescription getCommandDescription()

{

return new RedisCommandDescription(RedisCommand.HSET, "flink");

}

public String getKeyFromData(Tuple2<String, Integer> data)

{

return data.f0;

}

public String getValueFromData(Tuple2<String, Integer> data)

{ return data.f1.toString();

}

}

}

测试运行

package com.scn;

import redis.clients.jedis.Jedis;

public class RedisTest{

public static void main(String args[])

{

Jedis jedis=new Jedis("127.0.0.1");

System.out.println("Server is running: " + jedis.ping());

System.out.println("result:"+jedis.hgetAll("flink"));

} }

9、Flink 读取 Kafka 数据写入到 Flume

我们将多个Tomcat Server的Web服务器,或者其他的网站服务器都看你而定,没台节点上都配置了Flume Agent,用来收集本地日志目录。然后在另一台节点配置了Flume Consolidation Agent,用来收集各个Web服务器的Flume Agent的数据,然后送入Kafka Cluster。然后Kafka Cluster的数据交由Flink Cluster消费,从而将数据展示在Web前端 flume1

ZooKeeper -server host:port cmd args

#主要作用是监听文件中的新增数据,采集到数据之后,输出到avro

# 注意:Flume agent的运行,主要就是配置source channel sink

# 下面的a1就是agent的代号,source叫r1 channel叫c1 sink叫k1

a1.sources = r1

a1.sinks = k1

a1.channels = c1

#对于source的配置描述 监听文件中的新增数据 exec

a1.sources.r1.type = exec

a1.sources.r1.command = tail -F /home/uplooking/data/data-clean/data-access.log

#对于sink的配置描述 使用avro日志做数据的消费

a1.sinks.k1.type = avro

a1.sinks.k1.hostname = localhost

a1.sinks.k1.port = 9000

#对于channel的配置描述 使用文件做数据的临时缓存 这种的安全性要高

a1.channels.c1.type = file

a1.channels.c1.checkpointDir = /home/uplooking/data/flume/checkpoint

a1.channels.c1.dataDirs = /home/uplooking/data/flume/data

#通过channel c1将source r1和sink k1关联起来

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

执行命令

flume-ng agent --conf conf -n a1 -f 上面这个文件的位置 >/dev/null 2>&1 &

flume2同上,都是一台web服务器

flume3

#主要作用是监听目录中的新增文件,采集到数据之后,输出到kafka

# 注意:Flume agent的运行,主要就是配置source channel sink

# 下面的a1就是agent的代号,source叫r1 channel叫c1 sink叫k1

a1.sources = r1

a1.sinks = k1

a1.channels = c1

#对于source的配置描述 监听avro

a1.sources.r1.type = avro

a1.sources.r1.bind = 0.0.0.0

a1.sources.r1.port = 9000

#对于sink的配置描述 使用kafka做数据的消费

a1.sinks.k1.type = org.apache.flume.sink.kafka.KafkaSink

a1.sinks.k1.topic = f-k-s

a1.sinks.k1.brokerList = 114.116.219.197:5008,114.116.220.98:5008,114.116.199.154:5008

a1.sinks.k1.requiredAcks = 1

a1.sinks.k1.batchSize = 20

#对于channel的配置描述 使用内存缓冲区域做数据的临时缓存

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

#通过channel c1将source r1和sink k1关联起来

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

flume-ng agent --conf conf -n a1 -f 上面这个文件的位置 >/dev/null 2>&1 &

flume+kafka+flink的整合

package com.ongbo.hotAnalysis

import java.sql.Timestamp

import java.util.Properties

import org.apache.flink.api.common.functions.AggregateFunction

import org.apache.flink.api.common.serialization.SimpleStringSchema

import org.apache.flink.api.common.state.{ListState, ListStateDescriptor}

import org.apache.flink.api.java.tuple.Tuple

import org.apache.flink.configuration.Configuration

import org.apache.flink.streaming.api.TimeCharacteristic

import org.apache.flink.streaming.api.functions.KeyedProcessFunction

import org.apache.flink.streaming.api.scala._

import org.apache.flink.streaming.api.scala.function.WindowFunction

import org.apache.flink.streaming.api.windowing.time.Time

import org.apache.flink.streaming.api.windowing.windows.TimeWindow

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer

import org.apache.flink.util.Collector

import scala.collection.mutable.ListBuffer

/*

*定义输入数据的样例类

*/

case class UserBehavior(userId: Long, itemId: Long, cateGoryId: Int,behavior: String, timestamp: Long)

//定义窗口聚合结果样例类

case class ItemViewCount(itemId: Long, windowEnd: Long, count: Long)

object HotItems {

def main(args: Array[String]): Unit = {

//1:创建执行环境

val env = StreamExecutionEnvironment.getExecutionEnvironment

env.setParallelism(1)

//设置为事件事件

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

//2:读取数据

/*kafka源*/

val properties = new Properties()

properties.setProperty("bootstrap.servers","114.116.219.197:5008,114.116.220.98:5008,114.116.199.154:5008")

properties.setProperty("group.id","web-consumer-group")

properties.setProperty("key.deserializer","org.apache.kafka.common.serialization.StringDeserializer")

properties.setProperty("value.deserializer","org.apache.kafka.common.serialization.StringDeserializer")

properties.setProperty("auto.offset.reset","latest")

val dataStream = env.addSource(new FlinkKafkaConsumer[String]("weblog", new SimpleStringSchema(),properties))

// val dataStream = env.readTextFile("/Users/ongbo/Maven/bin/UserBehaviorAnalysis/HotItemAnalysis/src/main/resources/UserBehavior.csv")

.map(data =>{

System.out.println("data:"+data)

val dataArray = data.split(",")

// if(dataArray(0).equals("ij"))

UserBehavior(dataArray(0).trim.toLong, dataArray(1).trim.toLong, dataArray(2).trim.toInt, dataArray(3).trim, dataArray(4).trim.toLong)

})

.assignAscendingTimestamps(_.timestamp * 1000L)

//3:transform处理数据

val processStream = dataStream

//筛选出埋点pv数据

.filter(_.behavior.equals("pv"))

//先对itemID进行分组

.keyBy(_.itemId)

//然后设置timeWindow,size为1小时,步长为5分钟的滑动窗口

.timeWindow(Time.seconds(20), Time.seconds(10))

//窗口聚合

.aggregate(new CountAgg(), new WindowResult())

.keyBy(_.windowEnd) //按照窗口分组

.process(new TopNHotItems(10))

//sink:输出数据

processStream.print("processStream::")

// dataStream.print()

//执行

env.execute("hot Items Job")

}

}

/*自定义预聚合函数*/

class CountAgg() extends AggregateFunction[UserBehavior, Long, Long]{

//累加器初始值

override def createAccumulator(): Long = 0

//每来一次就加一

override def add(in: UserBehavior, acc: Long): Long = acc+1

//

override def getResult(acc: Long): Long = acc

override def merge(acc: Long, acc1: Long): Long = acc + acc1

}

//自定义窗口函数,输出ItemViewCount

class WindowResult() extends WindowFunction[Long,ItemViewCount, Long, TimeWindow]{

override def apply(key: Long, window: TimeWindow, input: Iterable[Long], out: Collector[ItemViewCount]): Unit = {

out.collect(ItemViewCount(key,window.getEnd,input.iterator.next()))

}

}

//自定义处理函数

class TopNHotItems(topsize: Int) extends KeyedProcessFunction[Long, ItemViewCount, String] {

private var itemState: ListState[ItemViewCount] = _

override def open(parameters: Configuration): Unit = {

itemState = getRuntimeContext.getListState(new ListStateDescriptor[ItemViewCount]("item-state", classOf[ItemViewCount]))

}

override def processElement(value: ItemViewCount, ctx: KeyedProcessFunction[Long, ItemViewCount, String]#Context, out: Collector[String]): Unit = {

//把每条数据存入状态列表

itemState.add(value)

//注册一个定时器

ctx.timerService().registerEventTimeTimer(value.windowEnd + 1)

}

//定时器触发时,对所有的数据排序,并输出结果

override def onTimer(timestamp: Long, ctx: _root_.org.apache.flink.streaming.api.functions.KeyedProcessFunction[Long, _root_.com.ongbo.hotAnalysis.ItemViewCount, _root_.scala.Predef.String]#OnTimerContext, out: _root_.org.apache.flink.util.Collector[_root_.scala.Predef.String]): Unit = {

//将所有state中的数据取出,放到一个list Buffer中

val allItems: ListBuffer[ItemViewCount] = new ListBuffer()

import scala.collection.JavaConversions._

for(item <- itemState.get()){

allItems += item

}

//按照点计量count大小排序,sortBy默认是升序,并且取前三个

val sortedItems = allItems.sortBy(_.count)(Ordering.Long.reverse).take(topsize)

//清空状态

itemState.clear()

//格式化输出排名结果

val result : StringBuilder = new StringBuilder

result.append("时间:").append(new Timestamp(timestamp - 1)).append("\n")

//输出每一个商品信息

for(i<- sortedItems.indices){

val currentItem = sortedItems(i)

result.append("No").append(i+1).append(":")

.append(" 商品ID:").append(currentItem.itemId)

.append(" 浏览量:").append(currentItem.count).append("\n")

}

result.append("============================\n")

//控制输出频率

Thread.sleep(1000)

out.collect(result.toString())

}

}

/*自定义预聚合函数计算平均数*/

class AverageAgg() extends AggregateFunction[UserBehavior, (Long,Int), Double]{

override def createAccumulator(): (Long, Int) = (0L,0)

override def add(in: UserBehavior, acc: (Long, Int)): (Long, Int) = (acc._1+in.timestamp, acc._2+1)

override def getResult(acc: (Long, Int)): Double = acc._1 /acc._2

override def merge(acc: (Long, Int), acc1: (Long, Int)): (Long, Int) = (acc._1+acc1._1, acc._2+acc1._2)

}

下面往日志目录里面写日志

543462,1715,1464116,pv,1511658000

662867,2244074,1575622,pv,1511658000

561558,3611281,965809,pv,1511658000

894923,3076029,1879194,pv,1511658000

834377,4541270,3738615,pv,1511658000

315321,942195,4339722,pv,1511658000

625915,1162383,570735,pv,1511658000

578814,176722,982926,pv,1511658000

873335,1256540,1451783,pv,1511658000

429984,4625350,2355072,pv,1511658000

866796,534083,4203730,pv,1511658000

937166,321683,2355072,pv,1511658000

156905,2901727,3001296,pv,1511658000

758810,5109495,1575622,pv,1511658000

107304,111477,4173315,pv,1511658000

452437,3255022,5099474,pv,1511658000

813974,1332724,2520771,buy,1511658000

524395,3887779,2366905,pv,1511658000

470572,3760258,1299190,pv,1511658001

543789,3110556,4558987,cart,1511658001

354759,2191348,4756105,pv,1511658001

382009,2123538,4801426,pv,1511658001

677046,1598945,4145813,pv,1511658001

946161,3021357,1506018,pv,1511658001

464646,2512167,2733371,pv,1511658001

1007641,5046581,2355072,pv,1511658001

723938,4719377,1464116,pv,1511658001

513008,3472922,401357,pv,1511658001

769215,22738,2355072,pv,1511658002

652863,4967749,1320293,pv,1511658002

801610,900305,634390,pv,1511658002

411478,3259235,2667323,pv,1511658002

431664,764155,2520377,pv,1511658002

487768,4125503,2465336,pv,1511658002

223813,4104826,2042400,pv,1511658002

672849,1822977,4801426,fav,1511658002

550127,4602135,65362,pv,1511658002

205752,1467139,171529,pv,1511658002

64419,2029769,2729260,pv,1511658002

756093,2881426,2520377,pv,1511658002

48353,4362292,583014,pv,1511658002

355509,4712764,4082778,pv,1511658003

826492,4016552,2735466,pv,1511658003

624915,2243311,2520377,pv,1511658003

682317,655740,982926,fav,1511658003

677621,1051389,4801426,pv,1511658003

422974,4649255,4818107,pv,1511658003

86512,563566,4756105,pv,1511658003

565218,2331370,3607361,pv,1511658003

232313,4182588,1730376,pv,1511658003

436966,1329977,3607361,cart,1511658003

561158,269170,2342116,fav,1511658003

344379,3318242,2920476,cart,1511658003

858204,2450718,235534,pv,1511658004

833924,3190176,1051370,pv,1511658004

992993,1900968,3794706,fav,1511658004

911930,1150136,2131531,pv,1511658004

736959,319911,4756105,pv,1511658004

82170,3588374,2465336,pv,1511658004

587599,2067643,4818107,cart,1511658004

367451,15775,4756105,pv,1511658004

428316,2478780,4284875,pv,1511658004

284910,3680091,3829657,pv,1511658004

345119,737662,4357323,pv,1511658004

551442,1762997,1879194,pv,1511658004

550384,3908776,1029459,pv,1511658004

677500,4534693,2640118,pv,1511658004

398626,2791489,1467750,pv,1511658004

118053,3545571,2433095,pv,1511658005

457401,4063698,4801426,pv,1511658005

45105,3234847,3141941,fav,1511658005

604760,2661651,3738615,pv,1511658005

905383,2064903,2939262,cart,1511658005

740788,3657484,4936889,pv,1511658005

456838,1242724,4756105,fav,1511658005

585217,215764,2640118,pv,1511658006

658185,4025021,4048584,fav,1511658006

210431,2035568,2328673,pv,1511658006

602619,1838725,2247787,pv,1511658006

860388,3797303,4357323,pv,1511658006

175334,2624960,801221,pv,1511658006

72403,4249007,1320293,pv,1511658006

307385,2551880,4050612,pv,1511658006

819283,2094785,2520377,pv,1511658006

801272,565658,1158475,pv,1511658006

344680,3224461,4789432,pv,1511658006

125206,1102775,622168,pv,1511658006

59131,1960832,154040,pv,1511658006

252339,2455388,3745824,pv,1511658006

794780,4465604,4242717,pv,1511658007

388283,4701157,1457367,pv,1511658007

416261,2101120,1299190,pv,1511658007

231758,3622677,4758477,pv,1511658007

92253,642337,4135185,pv,1511658007

297958,1762578,4801426,pv,1511658007

786771,1940649,1320293,pv,1511658007

789048,3144191,2355072,pv,1511658007

895384,1138468,1602288,pv,1511658007

578800,1324176,4135836,pv,1511658007

886777,4606952,996587,pv,1511658008

364036,2340632,2924150,pv,1511658008

783973,3935641,982926,pv,1511658008

483113,1158047,2030976,pv,1511658008

321087,3987903,149192,fav,1511658008

986762,2704613,4217906,pv,1511658008

1003495,3717164,535180,pv,1511658008

32983,1445878,2030976,pv,1511658008

580912,1837669,4263418,pv,1511658008

498371,980167,3607361,cart,1511658008

14830,3878488,3002561,pv,1511658008

457499,4796667,2355072,pv,1511658008

879381,881945,3004853,pv,1511658008

606403,1404468,781315,pv,1511658008

543832,3007018,2735466,pv,1511658009

824188,161847,4801426,pv,1511658009

750784,4727562,1286537,cart,1511658009

87479,5157294,2158079,pv,1511658009

147730,1278040,4801426,pv,1511658009

865088,3924907,411153,pv,1511658009

1006129,1993506,2939262,pv,1511658009

401750,3127850,2640118,pv,1511658009

501335,2005713,1092085,pv,1511658009

266486,1777124,4672807,cart,1511658009

23125,4680673,1756314,buy,1511658009

309473,3665543,2640118,pv,1511658009

547966,693058,2129666,pv,1511658009

599118,2771420,4159072,pv,1511658010

684544,2335709,1451814,pv,1511658010

130320,2469137,4756105,pv,1511658010

464365,1474058,3794706,pv,1511658010

522088,4170363,149192,pv,1511658010

402626,3244134,4801426,pv,1511658010

19445,2183531,4756105,pv,1511658010

44670,5140156,2131531,fav,1511658010

522815,2092266,2355072,pv,1511658010

105757,4175185,3191556,cart,1511658010

585344,1858802,267209,pv,1511658010

412009,3422566,2355072,pv,1511658010

872433,1984468,2520377,pv,1511658010

463780,3377720,745134,pv,1511658010

359932,5035793,3002561,pv,1511658011

742048,3851196,4051859,pv,1511658011

778656,559998,4874384,pv,1511658011

326402,2103118,846990,pv,1511658011

453328,2158281,2920476,pv,1511658011

362515,1892018,883960,pv,1511658011

763534,2402567,3496816,pv,1511658011

935169,55330,4339722,pv,1511658011

361299,1505783,982926,pv,1511658011

628949,4210587,903809,cart,1511658011

989894,3419383,1474371,fav,1511658012

200517,4670782,4181361,cart,1511658012

664416,2941436,1789614,pv,1511658012

348706,2605837,4163659,pv,1511658012

959846,5083345,479837,pv,1511658012

848070,988062,2342116,pv,1511658012

897594,4298799,4173315,pv,1511658012

951961,1221785,4756105,pv,1511658012

549488,2423996,4022701,pv,1511658012

524655,1925334,2033408,pv,1511658013

738256,496639,3247211,pv,1511658013

778173,1032031,784897,cart,1511658013

990673,1476503,3102419,pv,1511658013

700498,1993845,4173315,pv,1511658013

905860,2369381,1158475,pv,1511658013

893832,1153119,982926,pv,1511658013

602895,3538101,4756105,pv,1511658013

542932,1360737,903809,pv,1511658013

283950,3179868,3171095,pv,1511658013

789348,3841875,737184,pv,1511658013

756750,3534407,4129924,fav,1511658013

196825,4765909,2885642,pv,1511658013

20676,2875398,2885642,pv,1511658013

228104,2062543,2355072,pv,1511658013

773198,4200289,982926,pv,1511658014

677896,2165635,1029459,pv,1511658014

158600,3312738,1697889,fav,1511658014

287521,972793,1194737,pv,1511658014

549674,625283,3767409,pv,1511658014

631139,4364531,384755,pv,1511658014

375063,4069076,3607361,pv,1511658014

306072,1966569,285583,pv,1511658014

643526,282851,1575622,pv,1511658014

764411,4580986,982926,pv,1511658014

976200,3266415,2355072,pv,1511658014

918987,298223,1859277,pv,1511658014

18430,1882195,1080785,pv,1511658014

629115,3093045,1320293,pv,1511658014

332520,5026647,2355072,pv,1511658014

476980,2311313,4801426,pv,1511658014

157636,4858109,672001,pv,1511658015

798555,1295731,2800021,pv,1511658015

494300,4333209,3002561,cart,1511658015

122406,2059276,4801426,pv,1511658015

437344,4061918,4558987,pv,1511658015

220037,2939369,3720767,buy,1511658015

537712,2563909,3100759,pv,1511658015

520145,4465657,1320293,pv,1511658015

38574,1201477,3125533,pv,1511658015

1014253,2963034,1464116,pv,1511658015

915638,4800478,2629787,pv,1511658015

768844,2116634,4757812,pv,1511658015

74745,2231297,323851,fav,1511658015

326607,3693156,2066955,pv,1511658015

651189,4000666,886203,pv,1511658015

778396,3607696,5012555,pv,1511658016

493284,127403,359388,pv,1511658016

254349,4445002,2355072,pv,1511658016

415381,3520931,2419959,pv,1511658016

516789,18479,4145813,pv,1511658016

644777,987403,982926,pv,1511658016

317457,1546479,3776866,pv,1511658016

156905,4377552,1168596,pv,1511658016

740608,2405231,4173315,pv,1511658016

341260,5034946,4756105,pv,1511658016

806318,3525976,3299155,pv,1511658016

674989,4568242,4284875,fav,1511658016

889043,5015057,1281171,pv,1511658017

912390,2303733,2735466,pv,1511658017

393656,3569818,3738615,pv,1511658017

225763,480292,500212,pv,1511658017

334506,3722390,411153,pv,1511658017

273314,4973721,4611962,pv,1511658017

663193,2108019,2003083,pv,1511658017

1000034,800784,982926,pv,1511658018

391116,1962121,4145813,pv,1511658018

40793,4153899,1320293,pv,1511658018

280358,2654723,2520377,pv,1511658018

344240,3712088,2390349,pv,1511658018

691026,4022625,1126526,pv,1511658018

688090,1502018,1879194,pv,1511658018

947196,2259297,1406426,pv,1511658018

518479,576777,411153,pv,1511658018

789309,5136896,2981856,pv,1511658018

248568,3349768,1045172,buy,1511658018

392176,3742963,2066955,pv,1511658018

460076,79067,4145813,fav,1511658018

415381,98283,1104384,pv,1511658018

104698,2500376,4159072,pv,1511658018

854096,4858377,4145813,pv,1511658018

587129,4427761,3776866,cart,1511658019

58778,630815,2355072,pv,1511658019

250968,2335179,2355072,pv,1511658019

380976,3933325,982926,pv,1511658019

904253,1055751,471212,pv,1511658019

907231,3686874,2812445,buy,1511658019

377042,3549064,2355072,pv,1511658019

356507,3220081,578983,pv,1511658019

753856,2167638,4048584,fav,1511658019

929073,1324319,1879194,pv,1511658019

43863,918139,982926,pv,1511658019

41109,4133170,3835723,buy,1511658020

108015,4751201,411153,pv,1511658020

285636,4130380,2355072,pv,1511658020

395049,4346219,570735,cart,1511658020

949647,4427447,4756105,pv,1511658020

306072,1296281,3720767,pv,1511658020

69580,3928745,2671397,pv,1511658020

735110,40025,2974419,cart,1511658020

365717,1391888,2030976,pv,1511658020

587754,4762986,3002561,pv,1511658020

183966,1424015,4672807,pv,1511658020

874905,876411,2465336,pv,1511658020

789333,3383623,344833,pv,1511658020

323387,1699578,982926,pv,1511658021

530376,205888,5071267,pv,1511658021

770137,1031049,154040,pv,1511658021

732889,283410,3607361,pv,1511658021

170558,3144143,2465336,pv,1511658021

1004611,201201,3419760,cart,1511658021

121442,5073040,2355072,pv,1511658021

511424,1078256,440901,pv,1511658021

810879,4042749,3607361,pv,1511658021

889013,1023293,634390,pv,1511658021

641439,183845,4357323,pv,1511658021

607188,3590098,2885642,pv,1511658021

789271,5057422,245312,buy,1511658021

350999,3956368,2945933,pv,1511658021

974720,4838031,2072473,cart,1511658021

460076,2147027,1320293,fav,1511658022

956539,3937435,4801426,pv,1511658022

682283,102982,1080785,pv,1511658022

133319,2817626,4801426,pv,1511658022

82010,2788503,1216617,pv,1511658022

417933,4159217,4756105,pv,1511658022

719252,2161152,4145813,pv,1511658022

386729,4115033,3343095,pv,1511658022

460076,3268126,737184,fav,1511658022

764871,564499,2640118,pv,1511658022

599118,2335010,4159072,pv,1511658022

463780,341543,820364,pv,1511658022

377108,493618,3975787,cart,1511658022

266094,3871120,2465336,pv,1511658022

392064,4974340,4558987,pv,1511658022

858761,5042307,4357323,pv,1511658023

266992,3559268,4869428,pv,1511658023

208833,3716643,383530,pv,1511658023

244463,5059853,4145813,pv,1511658023

874809,1024295,4466876,pv,1511658023

87520,1318574,4606718,pv,1511658023

483594,1088111,2827444,pv,1511658023

29206,4448187,4756105,pv,1511658023

186556,4070367,74446,pv,1511658023

190940,833331,4604594,pv,1511658023

201971,962676,2355072,pv,1511658023

180695,1716295,2565857,pv,1511658023

670681,4511840,846990,pv,1511658024

843075,3665269,1080785,fav,1511658024

409463,4443612,1722855,pv,1511658024

145550,3900777,4993094,pv,1511658024

608599,1097682,4082778,cart,1511658024

997866,3002287,4082778,pv,1511658024

436457,1884224,4915680,pv,1511658024

517112,4526678,2520377,pv,1511658024

659269,1605934,982926,pv,1511658025

195725,5000029,4450414,pv,1511658025

563203,1849653,4298656,pv,1511658025

669210,4843772,570735,pv,1511658025

445656,2581505,3381583,pv,1511658025

16103,3494764,2640118,pv,1511658025

175769,776327,2465336,pv,1511658025

960997,2649870,4756105,pv,1511658025

995188,3017896,2355072,pv,1511658025

475656,361127,3673049,pv,1511658025

940124,176753,4411949,pv,1511658025

538101,1732433,1787510,pv,1511658025

416871,4981228,2858794,pv,1511658025

256758,3889295,3800818,pv,1511658026

511279,4601104,4868797,pv,1511658026

880462,2780737,1859277,cart,1511658026

163323,258231,1029459,pv,1511658026

425634,4018832,4159072,pv,1511658026

932384,2428269,982926,pv,1511658026

565980,2988776,3075521,pv,1511658026

551219,281111,350027,pv,1511658026

65944,4309207,3159480,pv,1511658026

118861,512107,4145813,pv,1511658026

15696,1015021,3454970,pv,1511658027

425200,2455388,3745824,pv,1511658027

55330,465280,2355072,pv,1511658027

664146,1030747,3194735,fav,1511658027

587248,1384198,634390,pv,1511658027

472221,2895550,982926,pv,1511658027

173290,416572,360294,pv,1511658027

735750,2456660,1080785,pv,1511658027

420860,1949459,1288487,pv,1511658027

248955,229653,2195789,pv,1511658027

745774,4756886,800581,pv,1511658027

179889,2041935,2520377,pv,1511658027

287035,3836534,625430,pv,1511658028

196980,3445269,3108882,pv,1511658028

550480,974291,869231,pv,1511658028

585870,291358,4174942,pv,1511658028

165889,4364728,2615163,pv,1511658028

193922,4800535,3607361,pv,1511658028

660013,1364114,4801426,pv,1511658028

813479,158169,2355072,pv,1511658028

261948,4698781,2520377,pv,1511658028

120608,131099,876318,pv,1511658029

268407,584693,3158249,pv,1511658029

411536,2563526,4663501,pv,1511658029

502196,936753,4145813,pv,1511658029

652954,1362503,4284875,pv,1511658029

70758,3011543,2926020,pv,1511658029

684074,2288156,377676,pv,1511658029

515661,680174,2355072,pv,1511658029

322508,2466347,2465336,pv,1511658030

643826,4545733,873792,pv,1511658030

447146,1436416,4331400,pv,1511658030

646259,418486,119741,pv,1511658030

288397,1926504,149192,pv,1511658030

337203,1253410,405755,pv,1511658030

219642,2704585,4148053,pv,1511658030

992351,1452966,2303546,pv,1511658030

860477,4319079,149192,pv,1511658030

680394,2772093,3720767,pv,1511658030

667912,1047955,1320293,pv,1511658030

938116,2134897,2735466,pv,1511658030

276252,3465909,1299190,pv,1511658030

1004505,4048232,145519,pv,1511658031

954492,4932087,1320293,pv,1511658031

271586,151399,578983,pv,1511658031

629913,1014006,3702593,pv,1511658031

879398,2473922,4756105,pv,1511658031

644883,4961929,1573465,pv,1511658032

62574,169041,1807416,pv,1511658032

643095,5119949,4357323,pv,1511658032

14391,2367378,2920476,pv,1511658032

840495,3013895,2926020,pv,1511658032

846863,1607283,1132429,pv,1511658032

463414,4937993,3607361,pv,1511658032

743967,491563,4244487,pv,1511658032

571930,2104387,1646753,pv,1511658032

337203,2407315,4715650,pv,1511658032

87004,3581433,690811,pv,1511658032

808466,3209415,2355072,pv,1511658032

834242,2646442,4357323,pv,1511658032

5855,1547334,1120543,pv,1511658032

861315,4512645,3361496,fav,1511658032

128765,1897815,4756105,pv,1511658033

677500,4690832,3504022,pv,1511658033

594637,3443787,3747017,pv,1511658033

958078,952967,3177877,pv,1511658033

455903,1725977,3904106,pv,1511658033

441977,177176,50601,pv,1511658033

391280,4307461,982926,pv,1511658033

873094,2044886,2355072,pv,1511658033

664177,1293088,5053508,pv,1511658034

302778,3781391,1528133,pv,1511658034

475563,4841577,1275696,cart,1511658034

208142,3139742,4756105,pv,1511658034

138026,3709805,3672452,pv,1511658034

534394,3020956,2355072,pv,1511658034

387963,1177970,2885642,pv,1511658034

334506,2951108,411153,pv,1511658034

274331,2394590,1464116,pv,1511658034

356279,829406,1102540,pv,1511658034

775853,3788823,4217906,pv,1511658034

156203,4938048,2383838,pv,1511658034

572844,1438423,2520377,pv,1511658035

987111,2263608,245312,pv,1511658035

231038,708261,1964754,fav,1511658035

81884,2437934,753984,pv,1511658035

942856,4215633,4756105,pv,1511658035

208061,2916548,4692440,pv,1511658035

495163,5100809,1879194,pv,1511658035

43237,2393443,2355072,pv,1511658036

750878,4729766,4672807,pv,1511658036

882734,4273237,1540741,pv,1511658036

400141,1714043,237446,pv,1511658036

585344,646781,267209,pv,1511658036

227633,3498188,4476428,pv,1511658036

284584,2019640,3607361,cart,1511658036

988694,3542016,982926,pv,1511658036

164332,3158500,235534,pv,1511658036

945934,2793460,3720767,pv,1511658036

691649,437087,223690,pv,1511658036

128816,2803125,3637084,pv,1511658036

715158,1448525,1842993,pv,1511658036

606841,4290041,3299155,cart,1511658037

655163,3409614,4357323,pv,1511658037

337203,1253410,405755,pv,1511658037

169609,4290998,4731191,pv,1511658037

515001,4142409,2735466,pv,1511658037

525614,4397050,3738615,pv,1511658037

48008,3043421,4239038,pv,1511658037

1015928,2849670,2735466,pv,1511658037

408783,703194,2885642,pv,1511658037

42364,3978662,611849,pv,1511658037

790128,4946853,2096639,pv,1511658038

226081,689681,4756105,pv,1511658038

774686,96790,2188684,pv,1511658038

317012,1665474,2355072,pv,1511658038

211077,990967,570735,pv,1511658038

879481,3523697,2154867,pv,1511658038

24625,5074681,2465336,pv,1511658038

638709,3848680,1575622,pv,1511658038

178232,1413610,149192,pv,1511658038

19742,4388000,200278,pv,1511658038

216011,2678565,1548278,pv,1511658038

709957,1969563,4606718,pv,1511658038

106526,856738,1080785,pv,1511658038

325562,363858,2735466,pv,1511658038

979063,2452027,4022701,pv,1511658038

451072,1035375,1320293,pv,1511658038

374336,3615843,4801426,pv,1511658038

466049,140210,1132429,pv,1511658038

38369,1780938,4357323,pv,1511658038

27948,1190005,1320293,pv,1511658038

212574,321621,4756105,pv,1511658039

793295,2941339,149192,pv,1511658039

971953,1503702,4756105,pv,1511658039

270332,1751547,4718907,pv,1511658039

261666,5141180,2355072,pv,1511658039

79249,1336042,2465336,pv,1511658039

743689,3161594,4181361,pv,1511658039

187936,1209195,4145813,pv,1511658039

954462,2653229,2448593,pv,1511658039

505372,3578525,702060,pv,1511658039

492876,2648336,35290,pv,1511658039

572164,4818203,1464116,fav,1511658039

204115,3552080,2477357,pv,1511658039

342902,679860,4756105,pv,1511658039

上面就是模拟Web日志都一条条写入了Flume,然后flume就将其导入了Kafka,然后Flink作为消费者就会去消费数据,然后利用各种窗口操作就可以了OK。

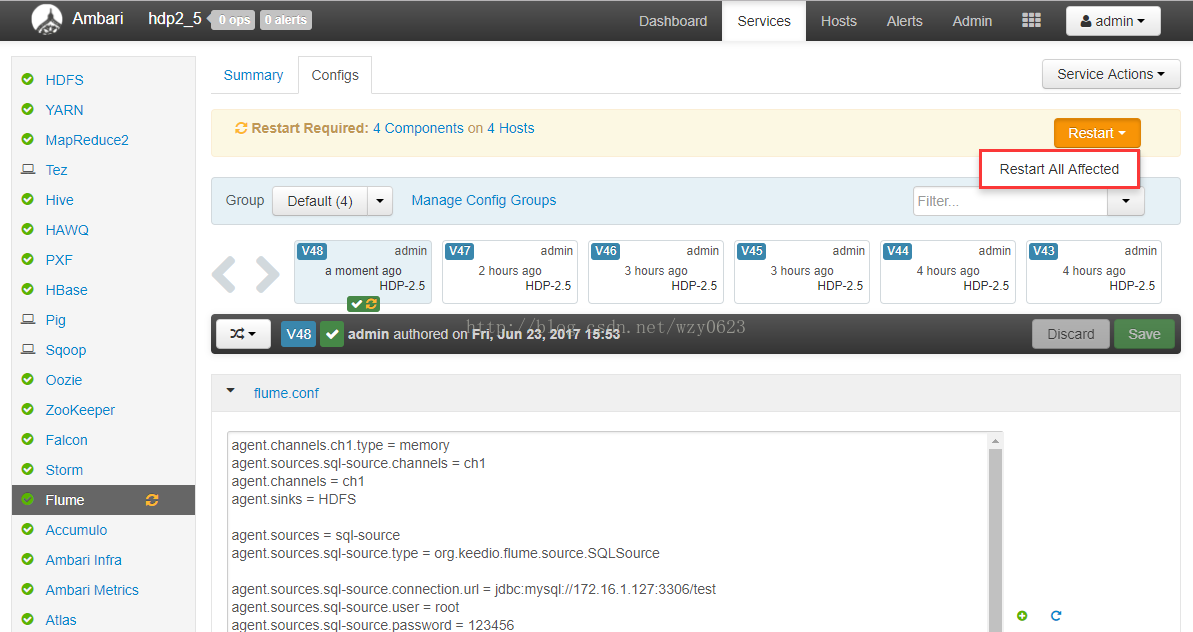

10、Flume将MySQL表数据准实时抽取到HDFS、MySQL、Kafka

软件版本号 jdk1.8、apache-flume-1.6.0-bin、kafka_2.8.0-0.8.0、zookeeper-3.4.5

集群环境安装请先测试;

参考以下作者信息,特此感谢;

①、利用Flume将MySQL表数据准实时抽取到HDFS

一、为什么要用到Flume 在以前搭建HAWQ数据仓库实验环境时,我使用Sqoop抽取从MySQL数据库增量抽取数据到HDFS,然后用HAWQ的外部表进行访问。这种方式只需要很少量的配置即可完成数据抽取任务,但缺点同样明显,那就是实时性。Sqoop使用MapReduce读写数据,而MapReduce是为了批处理场景设计的,目标是大吞吐量,并不太关心低延时问题。就像实验中所做的,每天定时增量抽取数据一次。 Flume是一个海量日志采集、聚合和传输的系统,支持在日志系统中定制各类数据发送方,用于收集数据。同时,Flume提供对数据进行简单处理,并写到各种数据接受方的能力。Flume以流方式处理数据,可作为代理持续运行。当新的数据可用时,Flume能够立即获取数据并输出至目标,这样就可以在很大程度上解决实时性问题。 Flume是最初只是一个日志收集器,但随着flume-ng-sql-source插件的出现,使得Flume从关系数据库采集数据成为可能。下面简单介绍Flume,并详细说明如何配置Flume将MySQL表数据准实时抽取到HDFS。

二、Flume简介

Flume的概念 Flume是分布式的日志收集系统,它将各个服务器中的数据收集起来并送到指定的地方去,比如说送到HDFS,简单来说flume就是收集日志的,其架构如图1所示。

Event的概念 在这里有必要先介绍一下Flume中event的相关概念:Flume的核心是把数据从数据源(source)收集过来,在将收集到的数据送到指定的目的地(sink)。为了保证输送的过程一定成功,在送到目的地(sink)之前,会先缓存数据(channel),待数据真正到达目的地(sink)后,Flume再删除自己缓存的数据。 在整个数据的传输的过程中,流动的是event,即事务保证是在event级别进行的。那么什么是event呢?Event将传输的数据进行封装,是Flume传输数据的基本单位,如果是文本文件,通常是一行记录。Event也是事务的基本单位。Event从source,流向channel,再到sink,本身为一个字节数组,并可携带headers(头信息)信息。Event代表着一个数据的最小完整单元,从外部数据源来,向外部的目的地去。

Flume架构介绍 Flume之所以这么神奇,是源于它自身的一个设计,这个设计就是agent。Agent本身是一个Java进程,运行在日志收集节点——所谓日志收集节点就是服务器节点。 Agent里面包含3个核心的组件:source、channel和sink,类似生产者、仓库、消费者的架构。 Source:source组件是专门用来收集数据的,可以处理各种类型、各种格式的日志数据,包括avro、thrift、exec、jms、spooling directory、netcat、sequence generator、syslog、http、legacy、自定义。 Channel:source组件把数据收集来以后,临时存放在channel中,即channel组件在agent中是专门用来存放临时数据的——对采集到的数据进行简单的缓存,可以存放在memory、jdbc、file等等。 Sink:sink组件是用于把数据发送到目的地的组件,目的地包括hdfs、logger、avro、thrift、ipc、file、null、Hbase、solr、自定义。

-

Flume的运行机制 Flume的核心就是一个agent,这个agent对外有两个进行交互的地方,一个是接受数据输入的source,一个是数据输出的sink,sink负责将数据发送到外部指定的目的地。source接收到数据之后,将数据发送给channel,chanel作为一个数据缓冲区会临时存放这些数据,随后sink会将channel中的数据发送到指定的地方,例如HDFS等。注意:只有在sink将channel中的数据成功发送出去之后,channel才会将临时数据进行删除,这种机制保证了数据传输的可靠性与安全性。

三、安装Hadoop和Flume

四、配置与测试

-

建立MySQL数据库表 建立测试表并添加数据。

use test;

create table wlslog

(id int not null,

time_stamp varchar(40),

category varchar(40),

type varchar(40),

servername varchar(40),

code varchar(40),

msg varchar(40),

primary key ( id )

);

insert into wlslog(id,time_stamp,category,type,servername,code,msg) values(1,'apr-8-2014-7:06:16-pm-pdt','notice','weblogicserver','adminserver','bea-000365','server state changed to standby');

insert into wlslog(id,time_stamp,category,type,servername,code,msg) values(2,'apr-8-2014-7:06:17-pm-pdt','notice','weblogicserver','adminserver','bea-000365','server state changed to starting');